اپل در گزارشی سه فناوری جدید را در جهت در حفظ امنیت کودکان از تصاویر کودکآزاری معرفی کرد. با این فناوری تمامی عکسهایی که در آیکلود بارگذاری میشوند جهت جلوگیری از سو استفاده جنسی کودکان اسکن خواهد شد. این مورد بسیار مورد نقد و بررسی قرار گرفته و خشم برخی از کاربران اپل را نیز بر انگیخته است. در این مطلب از انارمگ، هر آنچه دربارهی سیستم جدید حفظ امنیت کودکان در ios 15 با استفاده از فناوری اسکن اپل باید بدانید را برایتان آوردهایم.

آخرین اخبار اپل دربارهی اسکن CSAM

در ۱۳ اوت کریگ فدریگی، معاون اول نرم افزار اپل در مصاحبهای با وال استریت ژورنال گفت: طرز کار این سیستم بهطور گستردهای مورد تحریف و سواستفاده قرار گرفته است. وی در ادامه نحوهی کار سیستم را توضیح داد که در ادامه برایتان آوردهایم. اپل همچنین جزئیاتی دربارهی ویژگیهای امنیتی در Messages و ویژگی تشخیص CSAMمنتشر کرد.

گزارشی در رویترز اعلام کرد که صدها پیام نگرانکننده دربارهی این سیستم در کانال اپل منتشر شد.

اصول اولیه

فناوری جدید اپل چیست؟

اپل ویژگیهای جدید anti-CSAM خود را در سه حوزهی Messages ،iCloud Photos و Siri ارائه میدهد. نحوهی اجرای هر یک از آن ها با توجه به گفتههای اپل در اینجا آمده است.

Messages: برنامهی Messages از یادگیری ماشینی در دستگاهای اپل برای هشدار به کودکان و والدین در مورد محتوای حساس استفاده میکند.

iCloud Photos: قبل از ذخیرهی تصاویر در iCloud Photos یک فرایند روی دستگاه اپل برای آن تصویر در برابر هشدار های شناخته شدهی CSAM انجام میشود.

Siri و Search: در Siri و Search منبع اضافی را برای کمک به کودکان و والدین برای حفظ امنیت آنلاین و دریافت پیام در شرایط نا امن فراهم میکند.

سیستم جدید چه زمانی اجرایی میشود؟

اپل میگوید که ویژگی جدید Messages و iCloud Photos و Siri در iOS 15 و iPadOS ۱۵ و macOS عرضه خواهد شد. اپل اعلام نکرده است که این ویژگیها همزمان با ورود iOS 15 عرضه میشود یا خیر، بنابراین احتمال دارد که در بروزرسانیهای بعدی ارائه شود. برای اسکن iCloud Photos نیز تاریخ مشخصی اعلام نشده است اما به احتمال زیاد اواخر امسال وارد بازار میشود.

دلیل معرفی این سیستم چیست؟

کریگ فدریگی در مصاحبه با وال استریت ژورنال گفت: “دلیل انتشار آن با ios 15 این است که ما آن را کشف کردهایم! “

اسکن CSAM

آیا فناوری اسکن به این معنا است که اپل میتواند تصاویر کاربران را ببیند؟

نه دقیقا. اپل این فناوری را اینگونه توضیح میدهد: «به جای اسکن تصاویر در آیکلود، این سیستم با استفاده از پایگاه دادههای متشکل از هشدارهای شناختهشده CSAM که توسط سازمان امنیت کودکان NCMEC و دیگر سازمانهای حمایت از حقوق کودکان تهیه شده است، مطابقت تصاویر را بررسی می کند. اپل این پایگاه داده را به مجموعهای از هشدارهای ناخوشایند تبدیل و بطور ایمن در دستگاه کاربران ذخیره میکند.» همانطور که اپل توضیح میدهد این سیستم به شدت به دنبال تصاویر خاص و شناحته شده است. یک کارمند اپل فقط مسئول است که تصاویر قابل هشدار را برچسبگذاری کند و سیستم هر زمان با آن ها تلاقی داشته باشد هشدار میدهد.

آیا این که اپل تصاویر دستگاه کاربران را اسکن میکند درست است؟

جواب هم بله است و هم خیر. این یک سیستم چند وجهی است. اپل میگوید این سیستم برای کسانی که iCloud Photos را در آیفون خود غیر فعال کردهاند کار نمیکند. البته هنوز مسخص نیست که این اسکن تنها روی تصاویر بارگذاری شده در iCloud Photos انجام میشود یا همهی تصاویر. اما این مشخص است که نتایج اسکن ( و این که همخوانی دارد یا خیر ) تنها زمانی همراه تصاویر ارسال میشود که در آیکلود بارگذاری شده باشد. اپل میگوید: آیکلود نیمی دیگر از الگوریتم را انجام میدهد. بنابراین در حالی که تصاویر روی دستگاه اسکن میشوند برای تکمیل کار به آیکلود نیاز است. وی با تاکید میگوید که این سیستم عینا قسمتی از پروسه خطی ذخیرهی تصاویر در آیکلود است.

اگر سیستم تصاویر CSAM را تشخیص دهد چه اتفاقی خواهد افتاد؟

از آن جایی که سیستم تنها با تصاویر CSAM ارائه شده توسط NCMEC کار میکند، فقط تصاویری را گزارش میدهد که در تصاویر CSAM داخل iCloud Photos شناخته شدهاند. آستانهی تشخیص CSAM چیزی حدود ۳۰ ثانیه است. اپل قبل از این که تصمیم بگیرد به NCMEC گزارش بدهد یک بررسی انسانی انجام میدهد. هیچ گزارش خودکاری هم به مراجع قانونی وجود ندارد.

آیا ممکن است سیستم تصویر واقعی کودک را به عنوان یک تصویر CSAM تشخیص دهد؟

این مورد بسیار بعید به نظر میرسد زیرا که سیستم فقط برای تشخیص تصاویر شناخته شده طراحی شده است. اپل میگوید امکان این که سیستم تصویری را به اشتباه تشخیص دهد کمتر از یک تریلیون است و حتی قبل از این که این اتفاق بیفتد یک بررسی انسانی قبل از گزارش به مقامات قانونی صورت خواهد گرفت. علاوه بر اینها فرایند تجدید نظر برای هر کسی که احساس میکند حساب او به اشتباه تشخیص داده شده است وجود دارد.

آیا میتوان از اسکن تصاویر CSAM در iCloud Photos جلوگیری کنیم؟

نه این امکان وجود ندارد. تنها راه این است که iCloud Photos را برای جلوگیری از کار این سیستم غیر فعال کنیم. هنوز کاملا مشخص نیست که آیا این کار باعث میشود که اسکن تصاویر روی دستگاه اپل بطور کامل غیر فعال شود یا خیر. اما قطعی است که این اسکنها تنها هنگامی که تصاویر در iCloud Photos بازگذاری شود توسط اپل بررسی خواهد شد.

Messages

آیا اپل تمام تصاویر ما در پیامها را نیز اسکن میکند؟

نه. تدابیر ایمنی اپل در پیامها تنها برای محافظت از کودکان طراحی شده است و فقط برای حسابهای مخصوص کودکان که در iCloud توسط خانواده ایجاد شده، اعمال میشود.

ساز و کار سیستم چگونه است؟

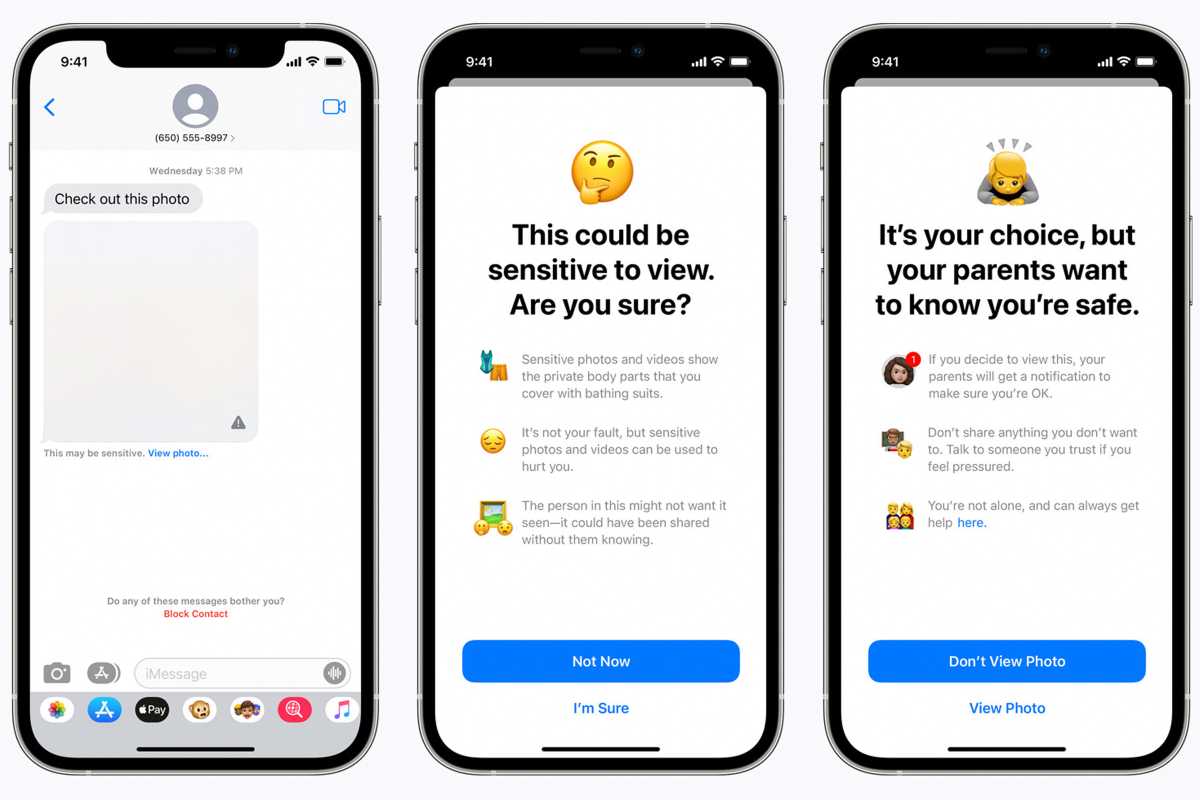

امنیت در پیامها برای کودکان یک سیستم متفاوت از اسکن CSAM برای iCloud Photos است. در این سیستم به جای مقایسه با تصاویر مشخص شده که امکان سو استفاده جنسی در آن ها است، تصاویر ارسال یا دریافت شده در پیامها را با استفاده از الگوریتم یادگیری ماشینی برای تشخیص هر گونه محتوای مرتبط با آزار و سو استفاده جنسی کودکان، بررسی و تجزیه و تحلیل میکنند. تصاویر با اپل یا هر انجمنی مانند NCMEC به اشتراک گذاشته نمیشود. این سیستمی است که میتوانند در حسابهای متعلق به کودکان برای هشدار اعمال کنند.

آیا والدین میتوانند این سیستم را غیر فعال کنند؟

والدین باید شخصا ویژگی جدید اسکن پیامها را در حسابهاای مخصوص کودکان فعال کنند و هر زمان که بخواهند میتوانند آن را غیر فعال کنند.

آیا iMessages هنوز رمزگذاری سراسری دارد؟

بله، اپل میگوید امنیت ارتباطات در پیامها ویژگیهای حریم خصوصی در پیامها را تغییر نخواهد داد و اپل هرگز به ارتباطات دسترسی پیدا نمیکند. علاوه بر اینها اپل در ارتباطات، ارزیابی تصاویر و اعلانها دخالتی ندارد.

در صورتی که یک تصویر واضح جنسی کشف شود چه خواهد شد؟

هنگامی که والدین این ویژگی را برای حساب کودکان فعال کرده و کودک تصویر واضح جنسی را دریافت یا ارسال کند، تصویر تار خواهد شد و هشداری به او داده می شود که در صورتی که نمیخواهد تصویر را مشاهده نکند. برای حسابهای متعلق به کودکان زیر ۱۲ سال، والدین میتوانند parental notifications ( اعلانهای مخصوص والدین) را فعال کنند، تا در صورت ارسال یا دریافت تصویری که مشخص شده مشکل جنسی دارد، به والدین اعلانی ارسال شود.

Siri و Search

اپل همچنین از Siri و Search برای گزارشهای تصاویر CSAM و جستجوهایی که امنیت کودکان را به خطر میاندازد و به دنبال آن اطلاع و هشدار به کودکان و والدین استفاده میکند. علاوه بر این Siri و Search را بروزرسانی میکند تا در صورتی که کاربران جستجوهایی مرتبط با CSAM انجام میدهند، مداخله کند. اپل میگوید این مداخله شامل ارسال هشدار به کاربر میشود و اطلاع از این که آیا به این مورد مشکل زا و مضر علاقه دارد یا خیر. همچنین منابع لازم برای کمک در این زمینه را فراهم میکند.

جنجال بر سر چیست؟ با این تقاسیر چرا مردم اعتراض دارند؟

در صورتی که اکثر مردم موافق با محدودهی دخالت اپل در این سیستم هستند، کارشناسان و ناظران و حامیان حفظ حریم خصوصی نگران احتمال سو استفاده در این زمینه هستند. به عنوان مثال ادوراد اسنودن، که برنامههای نظارتی جهانی توسط NSA را افشا کرد و در تبعید به سر میبرد، در توئییتی نوشت: مهم نیست نیت اپل خوب است یا نه، اپل با این کار نظارت گستردهای را در سراسر جهان اعمال خواهد کرد. اشتباه نکنید، اگر امروز بتوانند تصاویر نامناسب برای کودکان را اسکن کنند، فردا می توانند هر چیز دیگری را نیز اسکن کنند. علاوه بر این بنیاد مرزهای الکترونیکی نیز از این سیستم انتقاد کرد و متیو گریم، استاد رمزنگاری احتمال سو استفاده از سیستمی را که اپل طراحی کرده را توضیح داد.